الوصف

مع زيادة التكنولوجيا لتحسين أمان القيادة ، تزداد شعبية الكاميرا المحيطة بين الطرز الحديثة للعائلة التي تستخدم المركبات.

مع وفرة المعلومات التي جمعتها هذه الكاميرات ، هناك عدد قليل من الممارسات الحالية التي تقوم تلقائيًا بتحليل وفهم محتوى التسجيل. من خلال استخراج المعلومات من الفيديو ، يمكن للكمبيوتر فهم حالة القيادة والبيئة المحيطة بشكل أفضل. التطبيق الأكثر شيوعًا هو في مجال القيادة الذاتية ، حيث تحتاج السيارة إلى أن تكون قادرة على اكتشاف الأشياء والممر الأرضي ، وفهم إشارات المرور وكذلك الإشارات ، لاتخاذ قرار بشأن اتجاهها وسرعتها. بالنسبة للمركبة التي ليست ذاتية القيادة ولكنها مجهزة بكاميرات الرؤية الأمامية ، لا يزال من المفيد نشر العملية وتحليل التسجيل من خلال الاستدلال على قرار السائقين بناءً على الكائن المكتشف والمعلومات الأخرى المستفادة من التسجيل ، وربما تقديم المشورة المناسبة على سلوك السائقين.

يركز هذا المشروع على ثلاثة جوانب من معلومات القيادة:

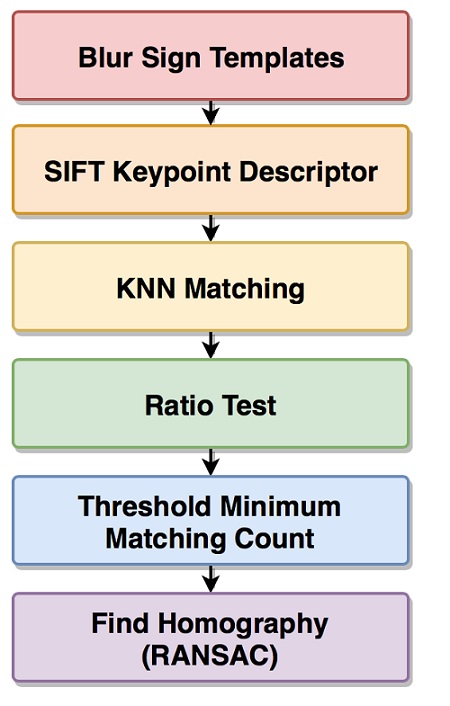

كشف علامات الطريق

التعرف على إشارة المرور (موجودة أم لا ولونها)

توقع سرعة القيادة وسرعة التوجيه ، والتنبؤ بحالة السيارة (على سبيل المثال ، للأمام ، والثابت ، والانعطاف لليسار)

يستخدم هذا المشروع تقنيات معالجة الصور لتطوير “مترجم فيديو” أساسي لكاميرا الرؤية الأمامية للسيارة ، والذي يسمح للكمبيوتر بفهم بعض المعلومات المهمة حول القيادة من خلال “مشاهدة” ما يمكن للسائق رؤيته. في الواقع ، هناك تقنيات أكثر تقدمًا يمكنها أداء نفس المهام بدقة أفضل بكثير. ومع ذلك ، فإن اكتشاف لافتات الطريق في هذا المشروع قادر على تحقيق دقة معتدلة. وبالمقارنة ، فإن الكشف عن إشارات المرور أكثر قوة ، وتنبؤات السرعة قادرة على تحقيق دقة معقولة.

Python code for Vehicle Make Detection by Convolutional Neural Networks

Python code take a a binary image which fed to the Tesseract OCR

Python code for Classification of photographic images based on perceived aesthetic quality

المراجعات

لا توجد مراجعات بعد.